Künstliche Intelligenz, KI, Artificial Intelligence oder AI ist eines der Schlagwörter, die im Zusammenhang mit der Digitalisierung unterschiedlicher Bereiche immer wieder genannt wird.

Leider bleibt oft unklar, worin diese “Intelligenz” denn eigentlich besteht. In dieser Kurzbeschreibung möchten wir auch für Nichtexperten verständlich darstellen, welche Techniken der künstlichen Intelligenz Topic Zoom verwendet und wozu diese in drei unterschiedlichen Dimensionen dienen.

TopicZoom Ontologien

Ein wichtiger Teil der KI bei TopicZoom geht auf den Einsatz von Ontologien bei der Textanalyse zurück.

Was ist eine Ontologie?

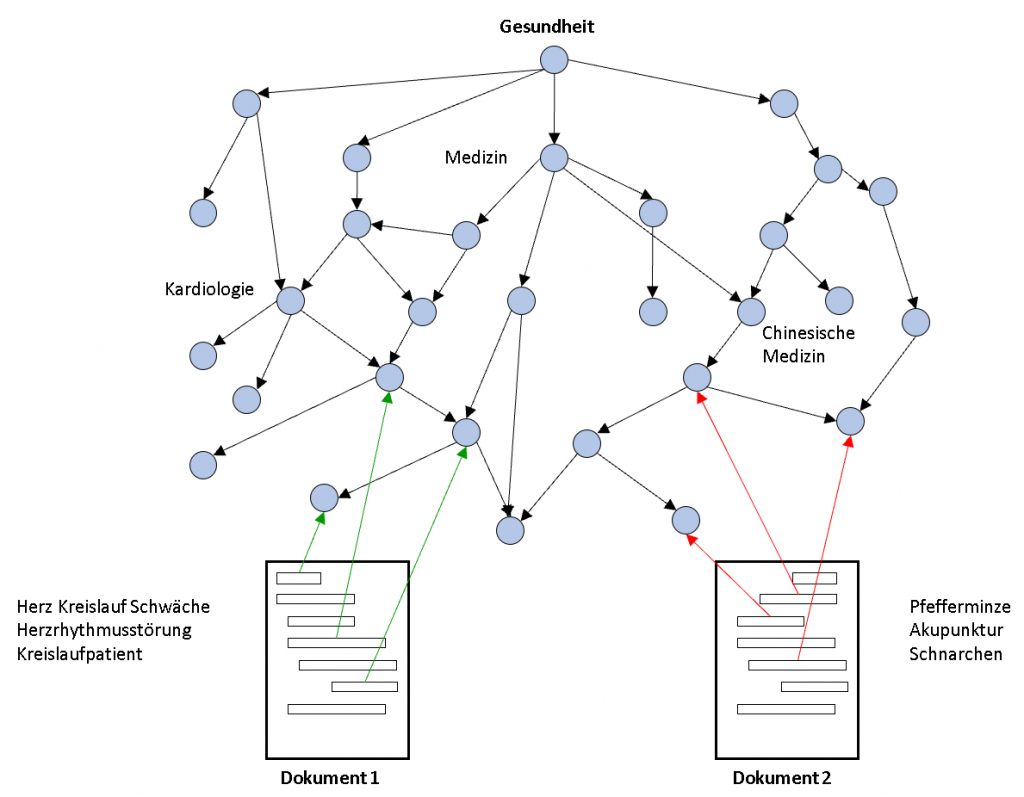

Der Begriff einer Ontologie wird uneinheitlich definiert. Unsere Ontologien bestehen aus “Konzepten” und einer hierarchischen Beziehung zwischen solchen Konzepten. Einfache Beispiele für Konzepte sind Themen wie ‘Politik’ oder ‘Veterinärmedizin’, geographische Bereiche wie ‘Asien’ oder ‘Hamburg’, Personen wie ‘Galileo Galilei’, Organisationen wie die ‘WHO’ und Ereignisse und Veranstaltungen wie ‚Australian Open‘. Aber auch ‘Veranstaltungen’ selbst ist ein Konzept, wie auch ‘Organisationen’. Konzepte sind in der Ontologie nach Allgemeinheit geordnet. Die Anordnung der Konzepte in der Ontologie kodiert Weltwissen, das normalerweise eine Maschine oder ein Rechner nicht besitzt. Beispielsweise wird das Weltwissen, dass Angela Merkel eine CDU-Politikerin und die deutsche Bundeskanzlerin ist, in der Ontologie dadurch festgehalten, dass das Konzept ‘Angela Merkel’ den allgemeineren Konzepten ‘Deutschland’, ‘Politikerinnen’ und ‘CDU’ hierarchisch untergeordnet ist.

Die “Kunst der Ontologieerstellung” besteht darin, eine immense Zahl von Konzepten in einem der allgemeinen menschlichen Intuition entsprechenden hierarchischen Netz anzuordnen.

Wie werden diese Ontologien bei der Textanalyse eingesetzt?

Die bei TopicZoom verwendeten Ontologien dienen der semantischen Analyse von Texten. Da ein und dasselbe Konzept in Texten in sehr unterschiedlichen sprachlichen Varianten auftreten kann (‘Gastritis’, ‘Magenentzündung’, ‘Entzündung des Magens’), reicht es nicht, für ein Konzept nur eine Bezeichnung zu speichern. Konzepte haben in unseren Ontologien eine Standardbezeichnung, zusammen mit dem Konzept sind aber in der Ontologie auch alle sprachlichen Benennungsvarianten mit erfasst. Diese wichtige Eigenschaft unterscheidet eine ‘computerlinguistische’ von einer rein ‘logischen’ Ontologie.

Auf diese Weise werden Konzepte sehr gut zuverlässig in Texten erkannt und semantisch eingeordnet . Darauf aufbauend werden für die im Text erwähnten Konzepte deren Beziehungen in der Ontologie genutzt, um auch auf Themen zu schließen, die im Text auftreten, ohne dass diese dort explizit genannt sein müssen. Das Analyseprogramm erkennt damit beispielsweise, dass ein Text, in dem das Konzept ‘Orionnebel’ auftritt, mit dem Thema ‘Astronomie’ verbunden ist. Zusammenfassend sind es also zwei Eigenschaften, die die Qualität einer computerlinguistischen Ontologie ausmachen: die Fähigkeit, trotz unterschiedlicher Formen der Benennung in Texten möglichst viele Konzepte korrekt zu erkennen, sowie die der menschlichen Intuition folgende Kodierung der vielfältigen Beziehungen zwischen Konzepten.

Die “künstliche Intelligenz” besteht hier also einerseits in der Verwendung von explizitem, nachprüfbaren Weltwissen bei der Textanalyse. Dieses Wissen über die Beziehung von Konzepten ist von Menschen zuvor erfasst und formalisiert! Es ist dadurch explizit, überprüfbar und abänderbar. Zum anderen besteht ein Teil der hier verwendeten “künstlichen Intelligenz” darin, dass Begriffe wie ‘Gastritis’ und ‘Magenentzündung’ als Synonyme, also als Ausdrücke gleicher Bedeutung erkannt werden.

Welche Ontologien werden bei TopicZoom eingesetzt?

TopicZoom ist ein führender Spezialist im Aufbau umfangreicher Ontologien. Bei der Textanalyse setzen wir standardmäßig eine hoch abdeckende allgemeine Ontologie mit ca. 200.000 Konzepten ein. Diese umfasst Konzepte, die nicht (oder nicht vorwiegend) fachspezifisch sind. Teile dieser allgemeinen Ontologie sind u.a.

– eine geographische Hierarchie mit Kontinenten, Staaten, Bundesstaaten, Landkreisen,

Städten und Gemeinden und Stadtteilen,

– eine temporale Hierarchie mit Zeitperioden wie ‘Kupferzeit’, ‘Mittelalter’, ’20. Jahrhundert’, bis zur Granularität von Jahren für spätere Perioden.

Zusätzlich zur allgemeinen Ontologie setzt TopicZoom bei bestimmten Anwendungen spezielle Fachontologien ein. Zu nennen sind hier die Bereiche “Medizin” oder “Recht und Justiz” für Einsatzgebiete wie die Analyse von Patientenberichten, für Suchmaschinen im Gesundheitsbereich, Tech-Law oder die Due Diligence.

Als Service bietet TopicZoom die Erstellung weiterer kundenspezifischer Spezialontologien an.

Mittels spezieller von uns angebotener Interfaces können Kunden spezielle Ontologien auch selbst erstellen.

Welche Vorteile ergeben sich aus der Verwendung der Ontologien?

Durch die Verwendung der Ontologien werden Bezüge eines Textes zu sehr vielen Themen und Konzepten deutlich, die dem reinen Wortlaut nach nicht im Text auftreten. Dadurch kann ein viel schärferes und aussagekräfigeres Bild der Textinhalte gewonnen werden, als dies mit üblichen wort- oder zeichenbasierten Methoden der Textanalyse möglich wäre. TopicZoom ergänzt dies durch unterschiedliche Scores und Relevanzangaben, die aufzeigen, wie wichtig oder auffallend das jeweilige Thema für den betrachteten Text ist. Insgesamt ergibt sich ein extrem detailliertes Bild des Texts, mit dessen Hilfe unterschiedlichste Aufgaben – von der Schlagwortextraktion über die Klassifikation bis zur Untersuchung einer Dokumentenbasis auf bestimmte kritische Inhalte – in optimaler Weise gelöst werden können.

Machine Learning, Deep Learning und Ontologien

Oft in einem Atemzug genannt mit KI sind Verfahren des maschinellen Lernens (Machine Learning), zu denen auch das vielzitierte “Deep Learning” zählt.

Was ist maschinelles Lernen?

Das Grundprinzip aller Verfahren des maschinellen Lernens besteht darin, die Werte bestimmter Merkmale der Eingabedaten (in der Fachliteratur „Features“ genannt) zu berechnen und zu gewichten. Beim Training der Verfahren werden für sehr viele Beispiele die extrahierten Merkmalswerte präsentiert sowie das im Einzelfall jeweils gewünschte Ergebnis (das korrekte „Label“, ein erwünschtes Verhalten, das nächste Wort in einem Text). Aus diesen vorgelegten Beispielen abstrahiert das Lernverfahren maschinell Strategien, wie man für andere Eingaben und die dort extrahierten Merkmalswerte das richtige, gewünschte Ergebnis erhalten kann. Mit Blick auf Anwendungsfelder und die Art der Eingabedaten ist ein prinzipieller Unterschied zu machen zwischen Bilderkennung und der Erkennung gesprochener Sprache einerseits und Anwendungen bei der Textanalyse andererseits.

Beim erstgenannten Anwendungsbereich sind die Eingabedaten Angaben zu Pixelverteilungen oder akustischen Signalen und damit einer numerischen Natur. Im Bereich der Textanalyse sind die Eingabedaten zeichen- oder wortbasiert. Interessanterweise kommen maschinelle Lernverfahren mit Pixeln oder akustischen Signalen wesentlich besser zurecht als mit sprachlichen Daten. So sind die teilweise beeindruckenden Erfolge bei der Bilderkennung nicht einmal ansatzweise auf die maschinelle Analyse von Sprache übertragbar. Vielleicht sollte das nicht überraschen. Man sieht ja in der Biologie, dass eine Katze oder ein Hund keinerlei Probleme haben, ein Auto, ein Bellen oder einen Futternapf perfekt zu erkennen, sich aber dennoch mit dem Lesen von Texten recht schwertun.

Wie lässt sich im Rahmen der Text- und Dokumentenanalyse maschinelles Lernen durch den Einsatz von Ontologien verbessern?

Ein zentrales Problem bei Anwendungen des maschinellen Lernens im Bereich Textanalyse ist es, aussagekräftige Merkmale zu finden. Die Lernverfahren erfassen ja nicht den „Text als Ganzes“, sie schauen ausschließlich auf die jeweiligen Werte der vorher festgesetzten Merkmale eines Texts! Aber auf welche Merkmale soll man beim Lernen aus Beispielen achten? Möchte man beispielsweise Texte in die Rubriken ‘Sport’ oder ‘Politik’ klassifizieren, macht es wenig Sinn, den Anteil der Vorkommen eines bestimmten Buchstabens im Text als Merkmal zu nehmen. Die gängigen Verfahren schauen darauf, wie oft bestimmte Wörter im Text auftreten. Etwas anspruchsvollere Verfahren ersetzen Wörter durch sogenannte Wortvektoren, die typische Umgebungen der Wörter mit einbeziehen.

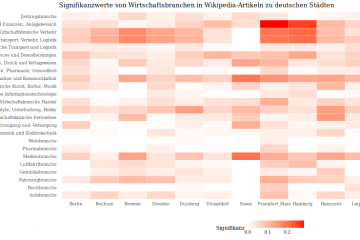

Wenn man sowohl die Trainingstexte wie auch die im Anwendungsfall zu klassifizierenden Texte mit den TopicZoom Ontologien analysiert, erhält man sofort ohne Aufwand eine große Zusatzauswahl sehr aussagekräftiger Textmerkmale. So wird z.B. mit Hilfe der Ontologie als ein „Merkmal des Textes“ sichtbar, wie viele Textbausteine einen Bezug zum Konzept/Thema ‘Sport’ bzw. zu ‘Politik’ haben. Das in der Ontologie formalisierte Wissen, dass ‚Australian Open‘ ein ‚Tennisturnier‘ ist, führt uns auf zwei weitere, feinere „Textmerkmale“: die Zahl der Textbausteine mit einem Bezug zum Konzept ‚Australian Open‘ bzw. zum übergeordneten Konzept ‚Tennisturniere‘. Damit unterstützen die ontologisch ermittelten Textmerkmale ganz direkt feinere, hierarchische Formen der Klassifikation (Sport→Tennis→Tennisturniere).

Mit seinen umfassenden Ontologien ist damit TopicZoom in der Lage, Verfahren des maschinellen Lernens durch ontologisch ermittelte Textmerkmale entscheidend zu verbessern, ähnlich wie ein Arzt mit Hilfe eines Fieberthermometers Krankheiten besser mit Hilfe des neuen Merkmals ‚Körpertemperatur‘ diagnostizieren kann. Insbesondere für schwierige Probleme beispielsweise aus dem Bereich der hierarchischen Klassifikation mit einer hohen Anzahl von Zielkategorien können deep-learning-basierte Algorithmen, die ontologisch ermittelte Textmerkmale miteinbeziehen, ihr volles Potential entfalten. Dies stellt insofern eine entscheidende Hilfe dar, als dass Deep Learning wie auch andere Lernverfahren in der industriellen Praxis gerade bei schwierigen Klassifikationsaufgaben fast immer vor dem Problem stehen, dass zu wenige ausreichend annotierte Daten für das Training zur Verfügung stehen.

Nachvollziehbarkeit, Erklärbarkeit der Ergebnisse, Fähigkeit zur Korrektur

Ein weiterer wichtiger Vorteil bei der Verwendung ontologischer Textmerkmale besteht in ihrer natürlichen Interpretierbarkeit und Erklärbarkeit. Jeder Laie versteht sofort, dass es beispielweise Sinn macht, die in der Ontologie aufgeführten Namen von Tennisturnieren als Textmerkmale zur Klassifikation einzusetzen. Wird dann ein Text später dem Bereich ‚Tennis‘ zugewiesen, kann man den Grund für dieses Klassifikationsverhalten ganz klar nachvollziehen. Eine Erklärung der Art „mein künstliches neuronales Netz hat das halt irgendwie so gelernt‘ erscheint im Vergleich völlig nutzlos. Angesichts der zunehmenden Diskussionen und rechtlichen Vorschriften im Hinblick auf ethisch verantwortliche, vertrauenswürdige KI ist eine nachvollziehbare Erklärung, warum ein System zu einem bestimmten Schluss kommt, sehr wünschenswert oder im Einzelfall sogar unbedingt erforderlich. Treten in einer Anwendung doch einmal Fehler auf, so sind entsprechende Schwachstellen der Ontologie leicht auffindbar und korrigierbar. Im Gegensatz hierzu ist es sehr schwer, ein Verhalten zu korrigieren, das „irgendwie“ beim sonstigen Lernen aus Trainingsdaten entstanden ist (Reverse Engineering durch die Black Box).

Kehren wir zur Ausgangsfrage zurück. Mit Blick auf Maschinelles Lernen, Deep Learning und Ontologien beruht die “künstliche Intelligenz” also zum einen darauf, dass das System überhaupt in der Lage ist, aus korrekt klassifizierten bzw. gelabelten Beispielen zu lernen. Ontologien sind hierbei wie zusätzliche Hilfsgeräte oder Diagnose-Instrumente: sie helfen dabei, beim Lernen aus Beispielen wie auch später beim Anwendungsfall viele neue interessante Merkmale miteinzubeziehen, für die andere Verfahren schlichtweg blind sind. TopicZoom bietet kein eigenes Standardprodukt im Bereich des maschinellen Lernens an. Indem wir jedoch vorhandene Systeme im Bereich Maschinelles Lernen und Deep Learning mit ontologischen Merkmalen anreichern, können wir zusammen mit Kunden spezielle leistungsstarke Lösungen entwickeln.

3. Patternerkennung in Texten mittels spezieller Grammatiken

Auch wenn Ontologien bei der Textanalyse sehr nützlich sind, stellen sie keine Allzweckwaffe dar. Viele Arten von Informationen, die in Texten stecken, sind nicht unmittelbar allein mit Hilfe von Konzepten beschreibbar. Betrachten wir als ein Beispiel die Angabe einer Bankverbindung. Hier überwiegen bestimmte Arten von Ziffern- und Buchstabenfolgen. Möchte man in Texten Bankverbindungen als solche erkennen, kann man einerseits Verfahren des maschinellen Lernens trainieren. Werden genügend positiv und negative Trainingsbeispiele vorgelegt und die Daten mit passenden Merkmalen beschrieben, kann dies gut funktionieren. Mit dem Blick auf die obigen Ausführungen bleibt auch hier ein Nachteil: wenn das System danach Fehler macht, lässt sich dieses Fehlerverhalten nur schwer korrigieren. Dazu müsste man sehen, was genau die Ursache des Fehlverhaltens ist und in entsprechender Weise das Trainingsset verändern. Dies kann jedoch zu neuen Fehlern führen.

Alternativ kann man Bankverbindungen durch Spezialgrammatiken beschreiben. So gibt es beispielweise klare Standards und Vorgaben, wie eine IBAN-Nummer aufgebaut sein kann. Diese Vorgaben lassen sich in Grammatikregeln übersetzen. Verallgemeinernd lassen sich Spezialgrammatiken erstellen, die beliebige Bankverbindungen recht zuverlässig erkennen. Treten hierbei Fehler auf, so lässt sich deren Ursache anhand der Regeln klar nachvollziehen und vergleichsweise leicht korrigieren.

TopicZoom bietet für ein umfangreiches Spektrum von bestimmten Informationen in Texten Spezialgrammatiken an, mit denen diese Inhalte erkannt werden. Hierzu zählen unter anderem Namen von Personen, Organisationen, Veranstaltungen, Datumsangaben, Geldbeträge, Bankverbindungen sowie Adressangaben unterschiedlichster Art.

Beim Einsatz dieser Verfahren etwa im Rahmen der Rechnungs- und Dokumentenanalyse, Anonymisierung oder Pseudonymisierung von Textdaten besteht die “künstliche Intelligenz” darin, dass in Gestalt der Grammatiken ein Teil des menschlichen Sprach- und Leseverständnisses formalisiert ist, so dass die Maschine ähnlich wie ein Mensch spezielle Informationen dieser Art in Texten erkennen und extrahieren oder verändern kann. Zur Beruhigung all derjenigen, die nun befürchten, dass das maschinelle Verständnis eines Textes damit bereits nahe dem menschlichen Verständnis ist: hier besteht nach wie vor ein immenser Unterschied. Mit den genannten Spezialgrammatiken lassen sich immer nur sehr spezielle Inhalte erfassen, und der Aufwand bei der Grammatikentwicklung ist in jedem Einzelfall substantiell. Im Vergleich mit dem natürlichen menschlichen Text- und Sprachverständnis ist – salopp gesagt – künstliche Intelligenz immer noch sehr künstlich und eingeschränkt. Trösten wir uns als Forscher und Entwickler mit dem oben verwendeten Bild: Hunde und Katzen können ja auch immer noch keine Texte verstehen!!

Bilder & Fotos:

Photo by Brett Jordan and by Hal Gatewood on Unsplash

Background vector created by starline – www.freepik.com